Trop longtemps délaissé et aujourd’hui plébiscité, Google Search Console est l’outil gratuit et fiable indispensable à toute stratégie SEO digne de ce nom.

Voici un rapide panorama des fonctions clés de la plateforme.

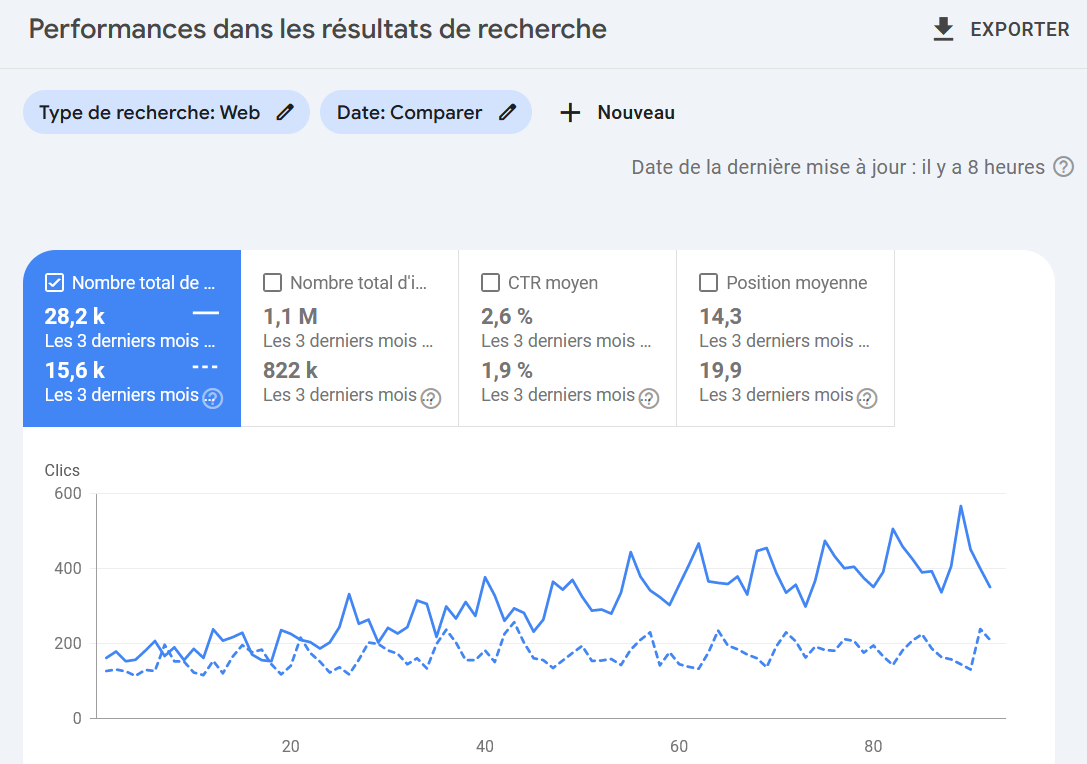

Google Search Console est le plus fiable des outils de suivi des performances SEO puisqu’il fournit les informations directement issues des clics arrivant depuis Google et non pas, comme Google Analytics des informations produites côté client, et donc beaucoup moins fiables.

Vous pourrez suivre 4 métriques :

Vous pourrez analyser ces données selon leurs dates :

Et particulièrement intéressant, vous pourrez analyser les recherches en les limitant à certains mots-clés ou à des pages particulières. Ceci vous permettra notamment d’identifier un point crucial du SEO qui est la proportion de requêtes de notoriété dans votre trafic SEO (la proportion d’utilisateurs qui saisissent votre nom de marque dans Google pour accéder à votre site).

Un conseil pour utiliser Search Console à pleine puissance : exportez les données via Looker Studio, d’une part pour accéder à l’intégralité des données, et d’autre part pour pouvoir les intégrer dans vos propres outils pour les analyser en profondeur. Pour commencer l’utilisation d’Excel et la combinaison de filtres sur plusieurs colonnes vous permettra d’activer facilement des analyses fines de données.

Google Search Console vous donne accès à l’information la plus précieuse qui soit pour l’optimisation SEO : quelles sont les requêtes qui sont saisies par les internautes. Celles qui génèrent des visites sur votre site, mais encore plus intéressant, aussi celles qui ont généré des affichages mais n’ont pas généré de visite.

S’agissant des requêtes des internautes, vous aurez grand intérêt à analyser les cas de figure suivants :

Moins intuitif l’analyse des performances de chaque page sera riche d’enseignements. Par exemple les requêtes associées à une page donnée vous permettent de vérifier que l’intention de recherche traitée par cette page est claire et précise (à défaut, peut-être auriez-vous intérêt à créer une page supplémentaire).

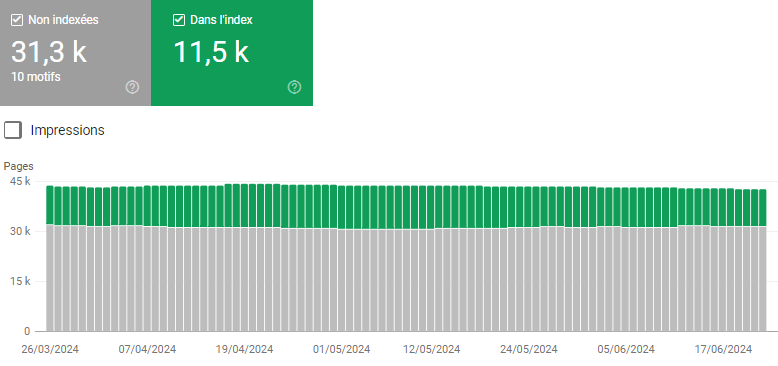

Le rapport d’indexation de la Google Search Console regorge d’informations sur l’état de santé SEO d’un site. Le premier graphe ci-contre donne l’état de l’indexation des urls connues de Google sur 3 mois. Le ratio idéal n’est pas nécessairement de 100% d’urls indexées.

Des urls non indexées peuvent l’être pour de bonnes raisons (bloquées par le fichier Robots.txt ou une balise noindex, redirections 301) et de mauvaises raisons (contenu dupliqué, erreurs 404, pages dépubliées en 302 ou redirigées en 301 mais recevant toujours des liens internes…). Réciproquement, toute url indexée n’est pas bonne à prendre, comme les urls de filtres à facettes, véritables pièges à robots.

Google catégorise les urls non indexées dans le rapport ci-dessus. La catégorie la plus infamante étant

“Détectées, non indexées” : Google n’a pas pris la peine d’explorer l’url !

L’analyse détaillée de ces données présente une forte valeur ajoutée SEO. Améliorer la qualité de votre indexation optimise le budget crawl de Google, donc l’explorabilité du site et, in fine, son trafic SEO. Cela passe par l’identification et la correction d’erreurs techniques, la suppression et la redirection de pages inutiles, le blocage de certains filtres avec le fichier Robots.txt.

Inversement, analyser les performances des pages indexées permet aussi d’identifier des pages à 0 clic, souvent inutiles, non optimisées ou faiblement accessibles. Ici, l’action consistera à faire un gros nettoyage et/ou à enrichir des contenus, optimiser le maillage interne, voire fusionner des pages.

A noter que la seule analyse des données d’indexation de la Google Search Console n’est pas suffisante pour les sites à fort volume d’urls pour lesquels un audit technique approfondi est nécessaire.

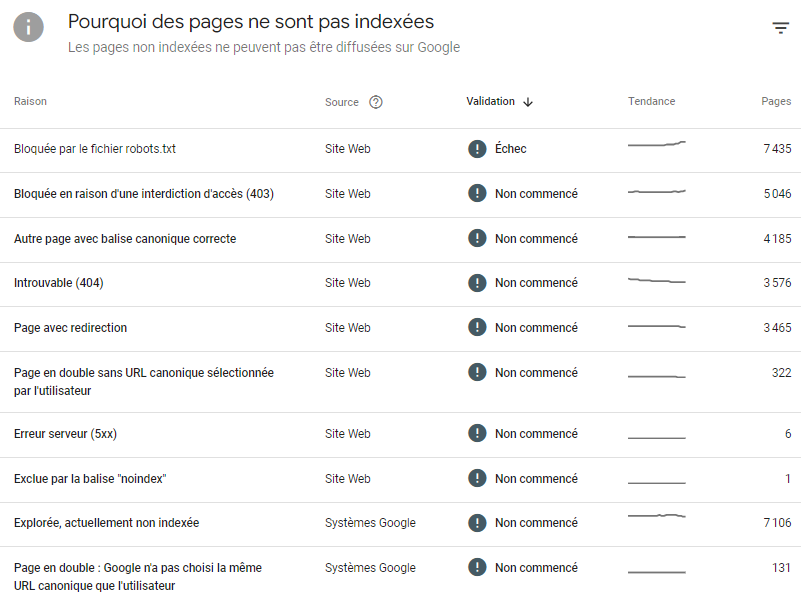

Voici une fonctionnalité bien cachée accessible dans Menu > Paramètres > Statistiques sur l’exploration.

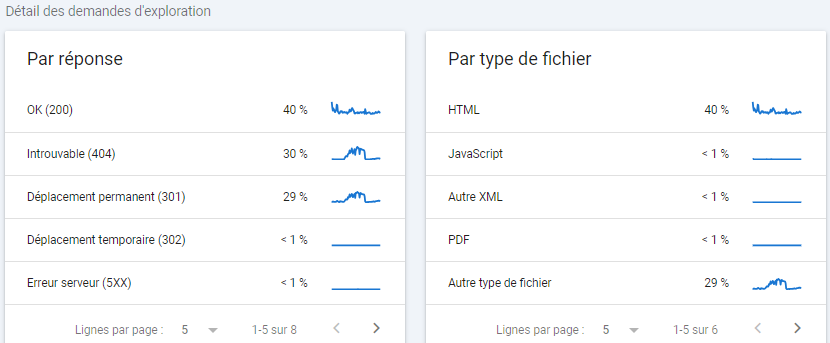

Ce rapport présente l’historique sur 90 jours des demandes d’exploration de Googlebot, des données téléchargées et du temps de réponse moyen des pages. Il recense aussi les problèmes éventuels de disponibilité de votre site en indiquant les raisons.

A droite, la courbe donne une vision globale du comportement de Googlebot et il est aisé d’identifier une anomalie. Ici, Google s’est anormalement excité quelques semaines : le robot interroge le site près de 3 fois plus qu’habituellement.

Et, s’il ne donne pas les raisons (à nous de les décoder), le rapport présente des pistes d’analyse en indiquant les taux d’exploration selon les réponses serveurs et les ressources rencontrées.

Ici, le problème vient clairement d’une hausse des erreurs 404 et des redirections 301 qui représentent près de 60% des demandes d’exploration sur les derniers 90 jours. Une fois le problème technique résolu, l’activité de Googlebot revient à la normale.

La Google Search Console présente 2 gros défauts :

Or, on peut brancher l’API de la Search Console à des outils tiers qui font ami-ami avec ses données pour repousser ses limites. Nous en avons choisi 3 que nous utilisons quotidiennement.

Olivier Duffez (Webrankinfo) et Fabien Facériès proposent avec My Ranking Metrics deux outils complémentaires.

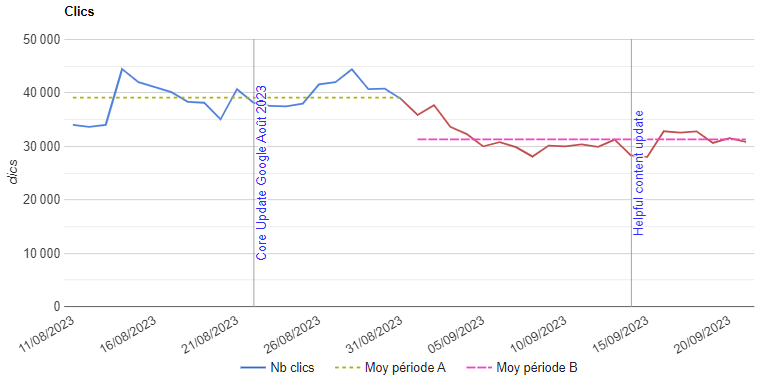

RM Console fait parler les données de performances (requêtes, urls, clics, impressions, positions, taux de clic), avec l’objectif d’identifier les opportunités de trafic. L’outil permet – entre autre – de clusteriser les urls et requêtes d’un site, de faire du suivi d’impact des optimisations, de mettre en place des alertes personnalisées ou d’analyser des chutes SEO comme ici.

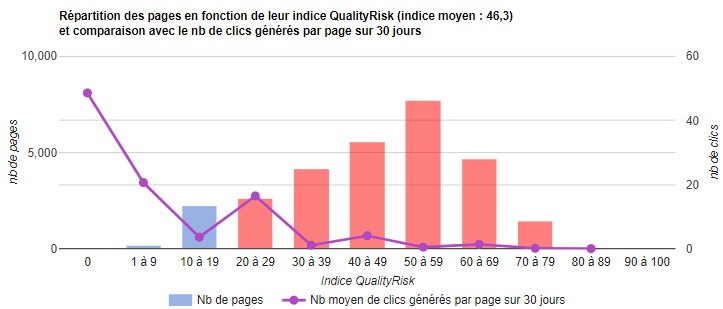

RM Tech est l’outil d’audit SEO technique de My Ranking Metrics. Outre les seules données techniques, il croise les données de crawl et d’indexabilité avec les clics de la Search Console. Les indices maison “QualityRisk” et “PagesZombie” permettent d’évaluer les (contre-)performances du site et d’identifier sur quelles urls agir.

Gratuit, Google Looker Studio peut aussi être connecté à l’API de la Search Console pour générer des reportings SEO sur-mesure. La limite des 1 000 requêtes affichées saute et vous avez une interface de lecture plus agréable que celle de la Google Search Console, mais cela peut demander pas mal d’huile de coude et il sera difficile d’atteindre la profondeur d’analyse de la RM Console qui présente déjà une première couche d’analyse des données.

Un bonus pour la fin, avec Screaming Frog. Contrairement, aux outils précités, il s’agit uniquement d’un outil de crawl SEO, non d’analyse qu’il faudra faire à la main. La connexion à la Google Search Console permet d’exporter les clics, impressions, positions, taux de clic des urls jusqu’à 16 mois : pratique pour préparer la migration d’un site de moyenne importance et ne pas oublier d’urls dans le plan de redirection. A noter que ScreamingFrog peut aussi interroger l’API d’inspection d’url pour connaître le statut d’indexation des 2 000 premières urls explorées. Intéressant pour l’analyse de l’indexation d’un petit site. Sinon, il faudra se tourner vers RM Tech qui est beaucoup plus puissant.