Data, voire big data ! Le mot est sur toutes les lèvres et le petit monde du SEO n’est pas épargné par la tendance. Pourquoi ? Les optimisations SEO classiques d’un site internet sont connues et appliquées (technique, éditorial, netlinking), mais l’homme a ses limites face à un volume de données conséquent à traiter ! Comment analyser les dizaines de milliers de pages d’un site – sinon plusieurs millions pour les mastodontes du e-commerce ? Quels métriques utiliser pour évaluer ses performances ? Quelles sont les applications concrètes des data SEO pour le référencement naturel ? C’est ici que Oncrawl fait son entrée. Objectif Papillon a pu tester l’outil et le moins que l’on puisse dire, c’est qu’il est puissant !

Oncrawl est un logiciel d’exploration de site internet en mode SAAS. La fonction de l’outil est d’explorer l’ensemble des urls d’un site internet à la manière des robots d’exploration de Google, de digérer toutes les données, et de les rendre intelligibles et analysables.

Oncrawl passe ainsi en revus les trois principaux facteurs de référencement d’un site internet : qualité technique, cohérence du contenu, valeur des liens (internes seulement). Sans être exhaustif, voici quelques dimensions prises en compte lors de l’exploration :

Oncrawl fait ensuite « parler » les données SEO via une interface très réussie et ergonomique.

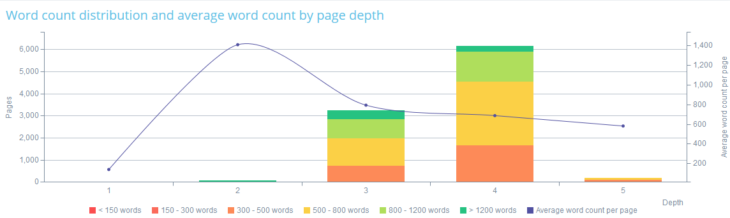

Ci-dessous, la distribution du volume de mots par page en fonction de la profondeur des pages d’un site e-commerce :

Clairement, le volume de contenu est faible et les pages riches sont mal réparties dans l’arborescence du site.

Un bon outil de crawl ne se résume pas aux données ci-dessus : l’idée est en effet de simuler au mieux l’exploration que pourrait faire un moteur de recherche de vos pages et d’en extraire, comme Google, les facteurs de pertinence et d’autorité qui feront ranker ces pages.

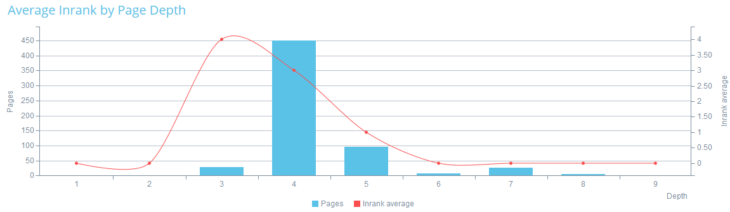

L’Inrank est un score de 0 à 10 donné par Oncrawl à chaque page interne afin d’en évaluer l’autorité. L’outil exploite le volume et la profondeur des liens pointant vers une url, les ancres de liens, ou la présence de contenus dupliqués.

Plus l’Inrank d’une page est élevé, plus Google a des chances de l’explorer régulièrement ; plus la page a une autorité élevée, plus sa visibilité SEO est élevée.

Autant dire que cette métrique est capitale pour évaluer la pertinence du maillage interne de votre site internet, donc la capacité de celui-ci à être bien référencé (mis à part les liens externes bien évidemment 😉 ).

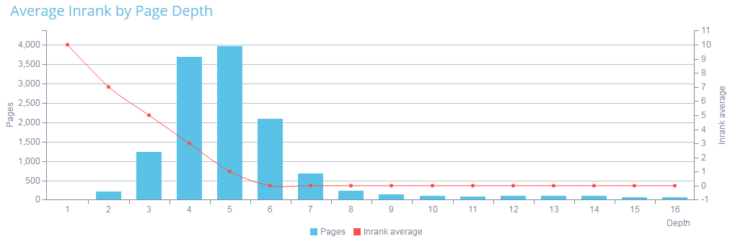

Ci-dessous, l’Inrank des pages d’un site en fonction de leur profondeur :

Selon les recommandations des équipes d’Oncrawl, la courbe rouge devrait être plate pour les pages stratégiques de niveau 2 et 3, voire 4. Le ratio entre la profondeur moyenne des pages et leur Inrank ne devrait pas dépasser 2. Ici, la distribution de l’Inrank ne serait pas optimale, l’écart étant relativement important selon le niveau de profondeur des pages (hors page d’accueil). Au-delà du niveau 3, les pages seront moins parcourues par les moteurs de recherche car moins bie maillées : leurs performances SEO seront donc moins bonnes.

L’action seo qui doit en découler est d’identifier si les pages stratégiques sont placées à une profondeur raisonnable et présentent un bon Inrank. Dans le cas contraire, il s’agit de comprendre pourquoi ces pages ne sont pas assez bien maillées, et d’optimiser en conséquence les liens internes.

Un bémol : une page présentant un contenu à haute valeur ajoutée, et recevant des liens externes de bonne qualité, pourra présenter de très bonnes performances seo. Or, si l’analyse d’Oncrawl la perçoit comme une page profonde avec peu de liens internes, elle présentera un faible Inrank.

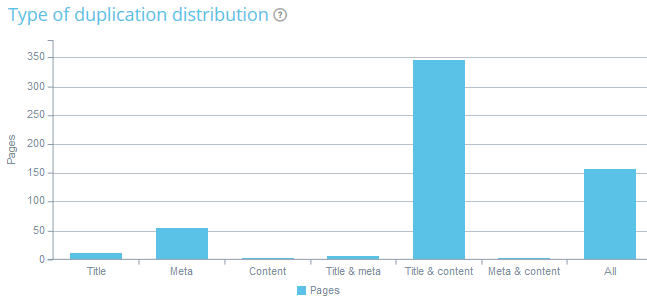

Une des forces d’Oncrawl est de pouvoir rapidement identifier les contenus dupliqués, de les classifier par catégories (balises et contenus éditoriaux), et de comprendre pourquoi ces contenus sont dupliqués.

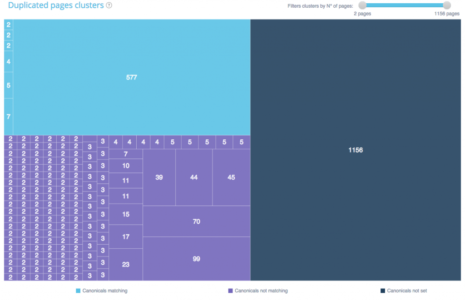

Oncrawl ventile aussi ces pages selon des clusters (=même relation sémantique), et la présence ou non de balises canoniques. La balise canonique permet par exemple d’indiquer à Google quelle est l’url à prendre en compte lorsque des paramètres de tri sont appliqués (tri par prix croissant, date, couleur, etc.).

En cliquant sur un cluster précis, nous arrivons à un groupe d’url. Il permet d’évaluer la similarité et de prendre les mesures adéquates :

Là où l’outil révèle toute sa puissance, c’est dans la capacité d’analyse de ces données. Car d’autres outils de crawl comme Xenu ou SreamingFrog font très bien le boulot et sont gratuits… Mais les rapports sont sous Excel, l’analyse doit être réalisée à la main, et le nombre de données explorées est sans commune mesure comparable. Nous parlons de Big Data appliquée au SEO, non ?

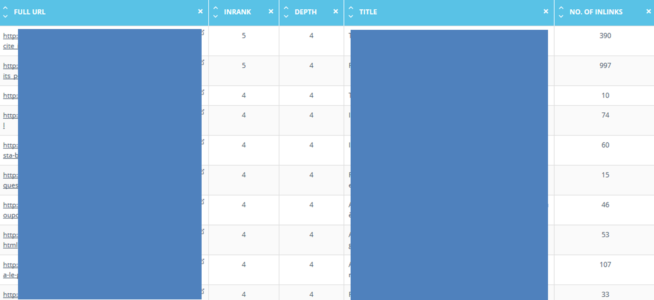

La fonction Data Explorer permet ainsi de réaliser aisément des tris croisés en fonction de toutes les données explorées par les robots d’Oncrawl. Il est aussi possible d’ajouter 3 types de filtres :

Fin du fin, les colonnes du tableau généré sont elles-mêmes configurables à l’envi selon toutes les variables d’Oncrawl : autant dire que les possibilités d’analyse SEO et d’optimisations sont quasi infinies pour les sites à gros volume d’urls.

Nous avons sélectionné l’ensemble des pages de niveau 4 d’un site e-commerce et ajouté une colonne « nombre de liens entrants » :

Les pages identifiées sont pour l’essentiel des pages produits : logique pour un site e-commerce. Cependant, on identifie rapidement un déséquilibre dans le nombre de liens reçus par ces pages. L’analyste fera le tri : pourquoi un page produit reçoit près de 1000 liens internes, alors qu’une autre au même niveau en reçoit 15 ?

Si la structure des urls du site le permet, il est possible de filtrer dans le Data Explorer de Oncraw un certain type de pages : les pages d’atterrissage par catégories produits (ex. : « électroménager », les pages produits d’une catégorie spécifique (ex : « aspirateurs) , etc.

Ci-dessous, nous avons créé un filtre permettant d’isoler des pages thématiques qui viennent soutenir l’offre produit. Rien d’étonnant à ce qu’elles soient au-delà du niveau 2.

Après analyse, il apparait que ces dernières pages correspondant à des contenus paginés (page 2, 3, 4…). L’optimisation consistera donc à améliorer la pagination pour améliorer leur accessibilité aux moteurs de recherche.

Oncrawl, utile ou non pour votre SEO ? 100 fois oui pour des sites présentant plusieurs milliers d’urls au minimum. Ici, Oncrawl a toute sa place dans votre boite à outil SEO. Moyennant un temps d’adaptation pour ne pas se perdre inutilement dans les méandres des big data, il vous permet de traiter rapidement un gros volume de données, d’évaluer la pertinence d’optimisations SEO, de réaliser des audits ponctuels, ou d’analyser les solutions techniques mises en place par vos concurrents pour booster leur référencement.

Pour un site de moindre envergure, la Google Search Console restera votre alliée favorite, à ceci près qu’elle ne pourra pas vous donner d’indications sur la pertinence de votre maillage interne, et restera muette sur la question des contenus dupliqués au-delà du rapport d’amélioration HTLM qui permet d’identifier les mata-tags en double.

Enfin, la grille tarifaire d’Oncrawl met l’outil à portée de toutes les bourses. Le forfait à 14€90 permet d’explorer 10 000 urls/mois pour 5 sites. C’est certes limité pour un site e-commerce, mais tout-à-fait adapté à l’audit d’un site internet classique et à l’analyse de ses concurrents. La version Pro à 24€90 d’Oncrawl que nous avons testée gratuitement repousse les limites à 100 000 url/mois pour 10 sites : cela nous paraît raisonnable pour un site e-commerce de moyenne importance. Sachez que l’offre Oncrawl permet d’aller jusqu’à 2 millions d’URL pour 249€/mois, mais tout le monde n’est pas Cdiscount, le partenaire du projet à son lancement.